oeil

#SUTOM #1234 3/6

🟥🟡🟦🟥🟦🟦🟦🟦 🟥🟥🟡🟥🟡🟡🟡🟦 🟥🟥🟥🟥🟥🟥🟥🟥

J'ai trouvé #pedantix nº1108 en 26 coups ! 🟩🟩🟩🟩🟩🟩🟩🟧🟧🟧🟧🟧🟧🟥🟥🟥🟥🟥🟥🟥 https://pedantix.certitudes.org/

En finale ! Bravo !

Snoopy a l'air si digne et fier de lui sur ce dessin.

Ah je n'ai encore jamais croisé cette astuce ! Tu me diras si ça marche.

Oui, j'ai remarqué ça aussi pour la liquidité de la pâte...

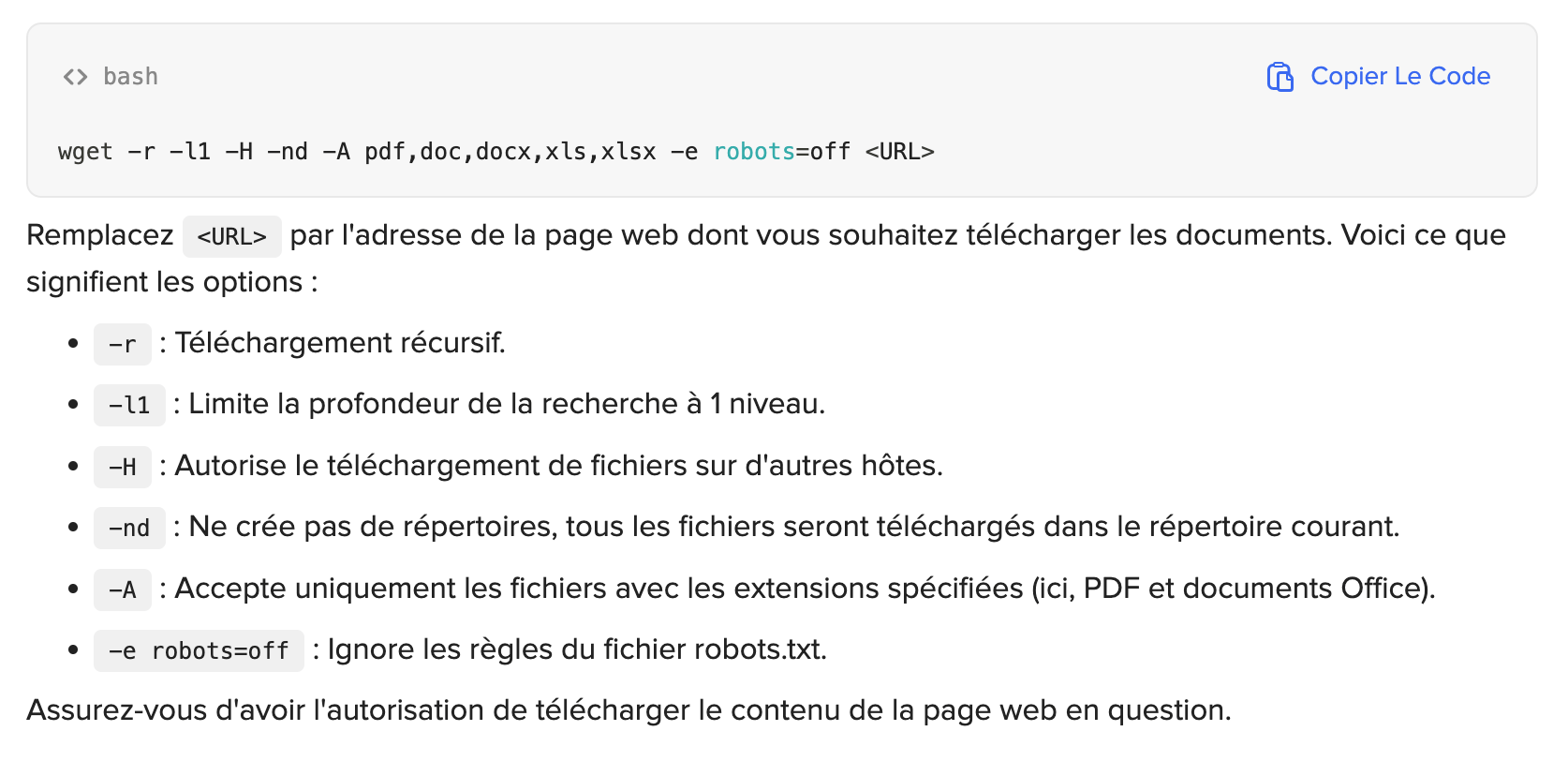

Pareil que toi, mais ça me semble bien contradictoire. Si je dis pas de bêtises, le document robots.txt est un document non contraignant, c'est plutôt une convention.

Le protocole d'exclusion des robots, plus connu sous le nom de robots.txt, est une convention visant à empêcher les robots d'exploration (web crawlers) d'accéder à tout ou une partie d'un site web.

Les robots peuvent ignorer votre fichier robots.txt, en particulier les robots malveillants qui crawlent les sites à la recherches de vulnérabilités ou d'adresses email

Le fichier robots.txt est un fichier accessible au public, ce qui signifie que n'importe qui peut voir ce que vous souhaitez ne pas faire indexer par les moteurs

Ah voilà, j'ai retrouvé le post d'@[email protected] (coucou!) à ce sujet : https://jlai.lu/post/16807807

According to Drew, LLM crawlers don't respect robots.txt requirements and include expensive endpoints like git blame, every page of every git log, and every commit in your repository. They do so using random User-Agents from tens of thousands of IP addresses, each one making no more than one HTTP request, trying to blend in with user traffic.

J'ai trouvé #pedantix nº1107 en 39 coups ! 🟩🟩🟩🟩🟩🟩🟩🟩🟧🟧🟧🟥🟥🟥🟥🟥🟥🟥🟥🟥 https://pedantix.certitudes.org/

#SUTOM #1233 4/6

🟥🟦🟦🟡🟦🟡🟡 🟥🟡🟦🟦🟡🟡🟦 🟥🟦🟡🟡🟦🟦🟥 🟥🟥🟥🟥🟥🟥🟥

Oui parfois il y a des gros ratés, souvent le gâteau qui ressort tout plat par exemple ◔̯◔

Bon et puis il faut oublier les pâtes à tarte bien élastiques tout ça, les pains aérés ಡ_ಡ

Et c'est vrai que c'est difficile de sortir de l'équivalent classique farine de riz (la nutritionniste que j'avais vu à l'hosto m'avait dit de faire attention à ça justement, ne pas tout remplacer par le riz).

J'aime bien la farine de manioc perso. Mais pas trop la farine de millet, que je trouve forte en goût et rapeuse. Pour le gonflant des gâteaux, je monte les œufs en neige.

Je modifie toujours les recettes pour les adapter au sans gluten, et je mélange les farines selon ce qu'il y a dans mes placards, ça donne toujours des surprises !

J'ai demandé à chatgpt via duck.ai de me rappeler la formule wget pour télécharger tous les documents pdf proposés sur une page internet.

Il m'a proposé ça :

C'est normal la commande pour ignorer robots.txt ?

Ps : je trouve ça dingue déjà

- qu'il le propose

- et en plus par défaut (je ne lui avais aucunement spécifié que les documents concernés étaient visés par le fichier robot.txt ; ce n'était d'ailleurs pas le cas)

Merci pour les infos !

À terme, le projet c'est de migrer jlai.lu sur piefed ?